В таджикском сегменте интернета разошлась фотография, на которой изображена якобы памирская девочка со снежным барсом. Фотография сопровождалась красивой историей о том, что девочка приручила барса, когда он еще был совсем маленьким и теперь он периодически спускается к ней. О том, что фотография создана нейросетью автор поста не указал.

Историей девочки и снежного барса поделились больше сотни пользователей. Хотя найти оригинал иллюстрации не составило труда. Оно было размещено на странице Travelbeautifulpakistan с указанием, что фото создано нейросетью Midjourney.

Посмотреть эту публикацию в Instagram

Мы расскажем как просто отличить иллюстрацию, созданную нейросетью, от реального фотоснимка, и какую роль сегодня играют фейковые снимки и видео.

Как распознать сгенерированный ИИ фотоконтент, опираясь на визуальные признаки?

Определить происхождение фото- или видеоматериала не всегда бывает просто, так как качество поддельного контента продолжает улучшаться, и отличить фейк от оригинала становится все труднее.

Так, весной 2023 года немецкий фотограф Борис Элдагсен представил на всемирный фотоконкурс Sony World Photography Awards одну из своих работ и одержал победу в номинации «Креатив».

Однако, как позже все-таки выяснилось, изображение на самом деле было сгенерировано искусственным интеллектом с использованием DALL-E 2. Элдагсен заявил, что хотел проверить, «готовы ли конкурсы к изображениям ИИ». В итоге фотограф решил отказаться от приза, поскольку его работа не была настоящей фотографией.

Фейковый контент в своих материалах зачастую используют работники СМИ: журналисты, которые, возможно, принимают созданные ИИ материалы за истину, не указывают, что фото созданы нейросетью.

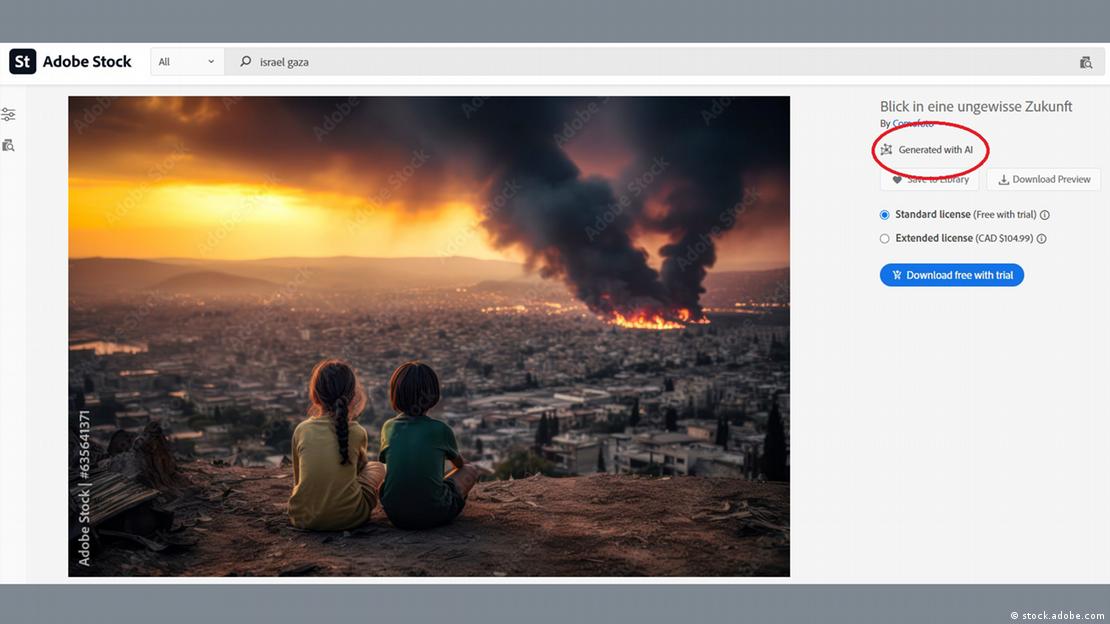

К примеру, осенью 2023 года, после начала военных действий на Ближнем Востоке, на сайте Newsbreak появилось изображение, на котором двое детей наблюдают из далека за огромными клубами дыма. Deutsche Welle, проведя обратный поиск изображений, выяснила, что фото сгенерировано нейросетью.

Редактор и старший аналитик украинского фактчекингового проекта VoxCheck Кирилл Перевощиков считает, что даже самый обычный пользователь интернета, не имеющий специальных инструментов, с большой вероятностью может распознать дипфейк.

«Главный инструмент, как бы пафосно это ни звучало, – это наша внимательность», – говорит аналитик.

В конце февраля этого года индийская англоязычная газета The Times of India опубликовала мини-гайд от государственного информационного бюро Индии Fact Check. Чтобы установить, сгенерировано ли фото ИИ, индийское пресс-бюро рекомендует обратить внимание на такие детали как:

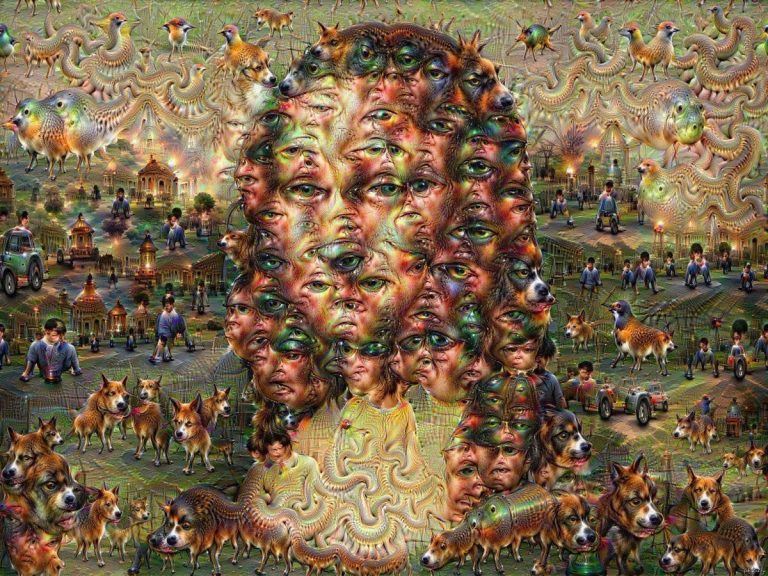

* отсутствующие пальцы, размытые текстуры и ошибки в тексте на изображении. Внимательно изучите пряди волос, форму тела и кожу человека на фото – обратите внимание, имеются ли поры на лице, есть ли на теле неправильные или неестественные черты. Посмотрите, нет ли на фото необычных предметов, нарушающих законы гравитации. Обычно они указывают на то, что фото создано ИИ.

Кстати, некоторые ИИ стали реже ошибаться с пальцами, если обратите внимание на девочку со снежным барсом, все пальцы у нее на месте. В таких случаях, обращайте внимание на уши и глаза. ИИ еще не научились делать круглым зрачок. Если невозможно разглядеть глаза, как в нашем случае с девочкой, то посмотрите на глаза барса – зрачка на одном практически нет.

* Абсолютно симметричные черты лица. ИИ зачастую генерирует лица в высоком разрешении, но черты как правило неестественно симметричны. Обратите внимание на глаза, брови, губы и другие черты лица, которые выглядят настолько симметрично, будто бы их отзеркалили. Нереально красивое лицо тоже должно насторожить. ИИ склонен создавать детализированных, нереально красивых девушек и красивых парней

* Странное освещение и тени. нейросеть обычно не создает фотографии с максимально реалистичными тенями и освещением. Сгенерированные нейросетью фото также выделяет необычный цветовой контраст, который идет вразрез с естественным освещением.

* Другие странные детали. ИИ ничего не знает о моде или традиционной одежде. У него нет опыта, на который он мог бы ссылаться. Поэтому ищите несовпадающие пуговицы, неравномерно расположенные или не по размеру, рисунки на традиционной одежде, которые могут не совпадать с тем или иным регионом. ИИ не всегда понимает это правильно.

Как отмечает Кирилл Переворщиков, на ИИ-картинке можно заметить нестыковки: лишние или недостающие конечности, слишком «глянцевую» кожу, необычные символы.

Когда генерируют фото с группой людей, несколько человек на нем могут выглядеть как близнецы. Кроме того, если на подозрительном фото есть известные личности, стоит проверить первоисточник – действительно ли это изображение публиковалось на официальных каналах или в соцсетях этих людей.

Нередко дипфейки используются для создания изображений так называемых чудес природы.

«В прошлом году мы разоблачали фейк о том, что якобы моряки из Латинской Америки поймали самого большого в мире лобстера, и он выглядит по размеру как небольшой слон. Сам лобстер выглядит достаточно четко, а люди позади – замыленные, весь горизонт позади них завален. Все выглядит максимально фальшиво на таких фото», — говорит Переворщиков.

Сервисы по разоблачению поддельного контента

В разоблачении фотографий и картинок, созданных с помощью ИИ, может помочь обратный поиск изображений в любом поисковике (Google, Bing, Яндекс) – система покажет картинки, похожие или идентичные загруженным. В Яндексе лучше искать именно контент, созданный на русском языке.

Специалисты также упоминают сервисы Hive Moderation или AI or not, но у них есть ограничения функций, доступных бесплатно. При этом аналитики подчеркивают, что даже специальные программы не могут разоблачить все фейки – и в программах есть погрешности.

Кроме того, есть сервисы для проверки, которые доступны только отдельным специалистам или еще находятся в разработке и доступны крупным компаниям, государственным учреждениям, но не широкой аудитории.

Лучший способ не попадаться в ловушку дипфейков, считает Переворщиков, – читать качественные источники информации. И даже в случае использования соцсетей и мессенджеров, где может попадаться очень разная и не всегда достоверная информация, всегда можно подписаться на качественные медиа, напоминает аналитик.

Как создаются фейки и чем они опасны?

В последние годы возможности искусственного интеллекта значительно расширились. Сегодня практически любой человек может запросто создать фото, видео или аудиоматериалы, которые, на первый взгляд, выглядят абсолютно реалистично.

Существует огромное количество онлайн-сервисов и платформ, – как платных, так и бесплатных – с помощью которых можно сгенерировать визуальный контент. Такие сайты, как DALL-E, Midjourney и Stable Diffusion, сегодня переживают всплеск популярности.

Помимо изображений, нейросеть способна также создавать и видео: в феврале 2024 года создатели чат-бота ChatGPT представили нейросеть под названием Sora, которая мгновенно преобразует текст в короткие видеоролики.

Сгенерированные ИИ видеоролики называются дипфейками (англ. Deepfake). Зачастую дипфейки используются для дезинформации общественности, особенно в контексте войн и конфликтов.

Фото и видеоролики, созданные с помощью искусственного интеллекта, уже вносили свой вклад в дезинформацию во время войны в Украине – и продолжают это делать и сейчас.

Кирилл Перевощиков связывает тренд на дипфейки в пропаганде и дезинформации с тем, что технологии достаточно просты и доступны для рядового пользователя интернета – не нужно владеть навыками работы в сложных программах, достаточно иметь базовую подписку на один из высокотехнологичных сервисов за 1$.

По словам Кирилла Перевощикова, создать фейк гораздо легче, чем распознать его, так как инструменты для проверки фейков развиваются очень медленно.

«Мы как фактчекеры, журналисты, любые работники медиа всегда вынуждены запаздывать, потому что тратим больше ресурсов, времени, чтобы это разоблачить», – сказал Перевощиков в интервью телеканалу «Настоящее время».

Your.tj